El cambio climático, que provoca el aumento del nivel del mar y la intensificación de las tormentas, supone un riesgo de erosión sin precedentes para las costas de todo el mundo. Sin embargo, predecir con precisión los cambios en la línea costera resulta complejo, sobre todo en lo que respecta a las tendencias a largo plazo. Recientemente, el estudio colaborativo internacional ShoreShop2.0 evaluó el rendimiento de 34 modelos de predicción de la línea costera mediante pruebas a ciegas, revelando el estado actual de la modelización costera.

La línea de costa es el límite dinámico donde la tierra se encuentra con el mar, en constante cambio debido a las olas, las mareas, las tormentas y el aumento del nivel del mar. Aproximadamente el 24 % de las costas arenosas del mundo retroceden a un ritmo superior a 0,5 metros por año, y en algunas zonas, como la costa del Golfo de México en Estados Unidos, la tasa de erosión anual supera incluso los 20 metros.

Predecir los cambios en la línea costera es intrínsecamente difícil y complejo, y requiere considerar la interacción de múltiples factores, como la energía de las olas, el transporte de sedimentos y el aumento del nivel del mar. Realizar predicciones precisas a largo plazo resulta aún más complicado.

Los modelos modernos de predicción de la línea costera se pueden dividir en tres categorías: una se basa en la simulación física, como Delft3D y MIKE21, que se basan en la mecánica de fluidos y las ecuaciones de transporte de sedimentos; otra es un modelo híbrido que combina principios físicos con métodos basados en datos, como CoSMoS-COAST y LX-Shore; y la tercera es un modelo basado en datos que se basa completamente en técnicas estadísticas o de aprendizaje automático, como las redes LSTM y las arquitecturas Transformer.

A pesar de la gran variedad de modelos, la falta de criterios de evaluación unificados ha dificultado la comparación de su rendimiento. ¿Qué modelo ofrece las predicciones más precisas? La competición de pruebas a ciegas ShoreShop2.0 brinda una oportunidad perfecta para realizar comparaciones interdisciplinarias.

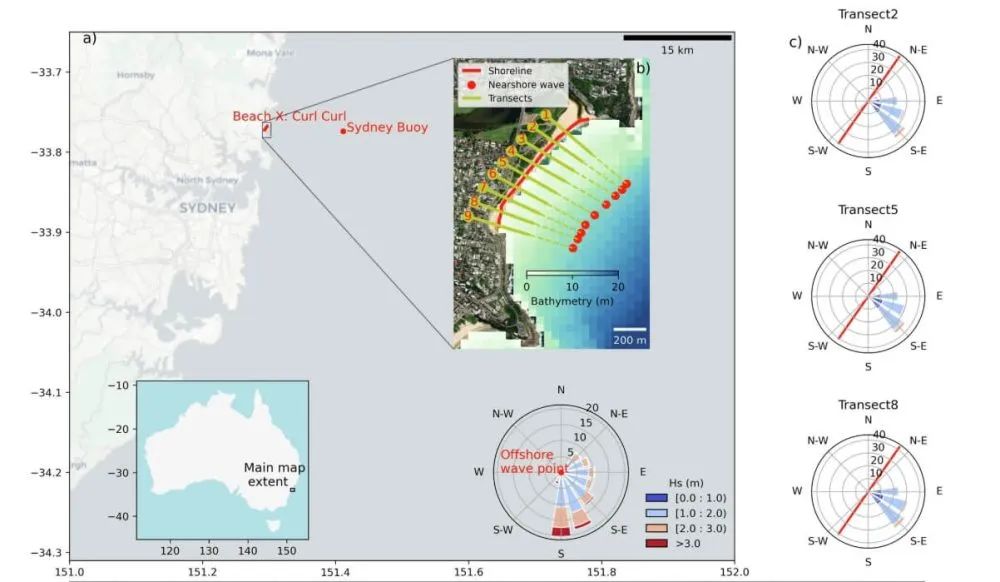

La competición internacional de pruebas a ciegas ShoreShop2.0 es una forma muy rigurosa de colaboración científica. Los equipos participantes solo conocen el lugar de la prueba, que es un nombre en clave para una bahía o playa. Información clave como su ubicación y nombre real se mantiene oculta para evitar que el conocimiento previo influya en la calibración del modelo. Además, los datos se mantienen confidenciales por secciones, y los datos de 2019-2023 (corto plazo) y 1951-1998 (medio plazo) se retienen intencionadamente. Los modelos predicen entonces los cambios en la línea de costa a corto y medio plazo, y finalmente verifican su precisión utilizando los datos confidenciales. Este diseño permite comparaciones interdisciplinarias de modelos costeros en condiciones totalmente desconocidas.

Treinta y cuatro equipos de investigación de 15 países presentaron modelos, que incluían 12 modelos basados en datos y 22 modelos híbridos. Estos equipos provenían de instituciones de Estados Unidos, Australia, Japón, Francia y otros países. Sin embargo, los modelos presentados carecían de modelos comerciales como GENESIS y los modelos basados en la física Delft3D y MIKE21.

Una comparación reveló que los modelos con mejor desempeño para pronósticos a corto plazo (cinco años) fueron CoSMoS-COAST-CONV_SV (modelo híbrido), GAT-LSTM_YM (modelo basado en datos) e iTransformer-KC (modelo basado en datos). Estos modelos alcanzaron errores cuadráticos medios de aproximadamente 10 metros, comparables al error inherente de 8,9 metros en los datos de teledetección satelital de la línea costera. Esto indica que, para algunas playas, la capacidad predictiva de los modelos se acerca a los límites de la tecnología de observación. Por supuesto, otros modelos lograron captar mejor los cambios en la línea costera.

Un hallazgo sorprendente fue que el modelo híbrido tuvo un rendimiento comparable al del modelo basado en datos. CoSMoS-COAST-CONV_SV (modelo híbrido) combina procesos físicos y operaciones convolucionales, mientras que GAT-LSTM_YM (modelo basado en datos) utiliza una red de atención gráfica para capturar correlaciones espaciales. Ambos modelos funcionaron bien.

En cuanto a las predicciones a medio plazo, la serie LX-Shore (modelos híbridos) ofrece las predicciones más cercanas a los datos medidos. Al combinar los procesos de transporte de sedimentos longitudinales y laterales, estos modelos mantienen la estabilidad a largo plazo y, al mismo tiempo, muestran las respuestas más consistentes ante tormentas extremas, en consonancia con los datos medidos. Las predicciones de estos modelos indican que una sola tormenta severa puede provocar un retroceso transitorio de la línea de costa de hasta 15-20 metros, cuya recuperación total podría tardar entre dos y tres años. La serie CoSMoS-COAST ofrece una excelente estabilidad, mientras que otros modelos pueden sufrir de deriva a largo plazo y sobreestimación de la respuesta.

Los resultados del modelo indican quecalidad de los datosEs un factor limitante clave en el rendimiento del modelo. Si bien los datos de teledetección satelital cubren una amplia zona, su resolución temporal es baja, generalmente semanal o mensual, lo que dificulta capturar la rápida recuperación posterior a una tormenta. Además, el límite instantáneo del agua se ve afectado por el oleaje y las mareas, lo que genera errores transitorios que pueden afectar las predicciones del modelo.

El estudio reveló que el suavizado de datos espaciotemporales, como el uso de técnicas robustas de filtrado bidimensional, puede mejorar significativamente el rendimiento del modelo. Posteriormente, los modelos de prueba no ciegos presentados redujeron el error promedio en un 15 % gracias a un preprocesamiento de datos optimizado.

El suavizado robusto 2D es un método avanzado de procesamiento de señales diseñado específicamente para eliminar el ruido en datos satelitales de zonas costeras. En esencia, se trata de un algoritmo de filtrado iterativo basado en mínimos cuadrados ponderados, y es altamente robusto ante valores atípicos como el ruido de olas transitorias en imágenes satelitales.

Otro factor crucial para las predicciones de los modelos es la precisión de los datos de oleaje costero. Actualmente, estos datos presentan diversos errores, como errores en la conversión a la zona costera de los datos de reanálisis global de oleaje, sesgos causados por la extracción de parámetros de oleaje en la isóbata de 10 metros en lugar de en la zona de rompiente, y la subestimación del impacto de eventos extremos al utilizar las condiciones promedio diarias del oleaje. Todos estos errores pueden afectar las predicciones de los modelos.

Para las predicciones a largo plazo, la mayoría de los modelos se basan en la ley browniana clásica para estimar el impacto del aumento del nivel del mar. Sin embargo, esta ley presupone un aporte de sedimentos infinito y equilibrado, e ignora los efectos del transporte de sedimentos hacia mar adentro o las actividades humanas, como la regeneración de playas. Esto puede generar sesgos significativos en los modelos.

Basándose en la teoría del perfil de equilibrio, la ley de Brown establece una relación lineal entre el aumento del nivel del mar y el retroceso de la línea de costa. Esta teoría postula que un perfil costero mantiene una forma de equilibrio. A medida que el nivel del mar aumenta, el incremento del espacio de acomodación obliga a este perfil de equilibrio a desplazarse tierra adentro para mantener su forma con respecto al nuevo nivel del mar. En consecuencia, la teoría postula que, a medida que el perfil costero se desplaza tierra adentro, la capa superior de la playa se erosiona y el material erosionado se deposita mar adentro, lo que provoca que el fondo marino cercano a la costa se eleve, manteniendo así una profundidad de agua constante. La ley de Brown predice que el retroceso costero puede ser de 10 a 50 veces mayor que el aumento del nivel del mar, dependiendo de la pendiente de la playa.

Este estudio sienta las bases para seleccionar las herramientas adecuadas según las necesidades específicas. Además, el preprocesamiento de datos es crucial; un procesamiento adecuado puede tener, en ocasiones, un mayor impacto que el propio modelo. A partir de la experiencia adquirida con ShoreShop 2.0, se pueden realizar mejoras en los datos satelitales y de oleaje para aumentar la precisión de las predicciones. Asimismo, los efectos incontrolables de las playas alteradas artificialmente en los pronósticos a largo plazo también pueden afectar significativamente los resultados. Por otra parte, la falta de participación de modelos comerciales como GENESIS, Delft3D y MIKE21 constituye un problema importante.

Guardianes de la Frontera Azul: La misión de Frankstar durante 11 años para proteger nuestros océanos y el clima.

Durante más de una década, Frankstar ha liderado la gestión ambiental marina, empleando tecnología de vanguardia y rigor científico para ofrecer datos oceánicos e hidrológicos sin precedentes. Nuestra misión va más allá de la simple recopilación de datos: somos artífices de un futuro sostenible, capacitando a instituciones, universidades y gobiernos de todo el mundo para que tomen decisiones informadas en favor de la salud de nuestro planeta.

Fecha de publicación: 11 de agosto de 2025