Face aux changements climatiques qui entraînent une montée des eaux et une intensification des tempêtes, les littoraux du monde entier sont confrontés à des risques d'érosion sans précédent. Or, la prévision précise de l'évolution du littoral, notamment des tendances à long terme, demeure complexe. Récemment, l'étude collaborative internationale ShoreShop2.0 a évalué la performance de 34 modèles de prévision du littoral par le biais de tests à l'aveugle, révélant ainsi l'état actuel des connaissances en matière de modélisation du littoral.

Le littoral est la frontière dynamique où la terre rencontre la mer, en perpétuelle évolution sous l'effet des vagues, des marées, des tempêtes et de la montée du niveau de la mer. Environ 24 % des côtes sableuses du monde reculent à un rythme supérieur à 0,5 mètre par an, et dans certaines régions, comme la côte du golfe du Mexique aux États-Unis, le taux d'érosion annuel dépasse même 20 mètres.

Prédire l'évolution du littoral est une tâche complexe et difficile, qui nécessite de prendre en compte l'interaction de multiples facteurs, tels que l'énergie des vagues, le transport de sédiments et l'élévation du niveau de la mer. Les prévisions précises sur le long terme sont encore plus ardues.

Les modèles modernes de prédiction du littoral peuvent être divisés en trois catégories : la première est basée sur la simulation physique, comme Delft3D et MIKE21, qui s’appuient sur la mécanique des fluides et les équations de transport des sédiments ; la deuxième est un modèle hybride qui combine des principes physiques avec des méthodes basées sur les données, comme CoSMoS-COAST et LX-Shore ; et la troisième est un modèle basé sur les données qui repose entièrement sur des techniques statistiques ou d’apprentissage automatique, comme les réseaux LSTM et les architectures Transformer.

Malgré la grande variété de modèles, l'absence de critères d'évaluation unifiés rend les comparaisons de performances difficiles. Quel modèle offre les prédictions les plus précises ? Le concours de tests à l'aveugle ShoreShop2.0 offre une occasion idéale de réaliser des comparaisons interdisciplinaires.

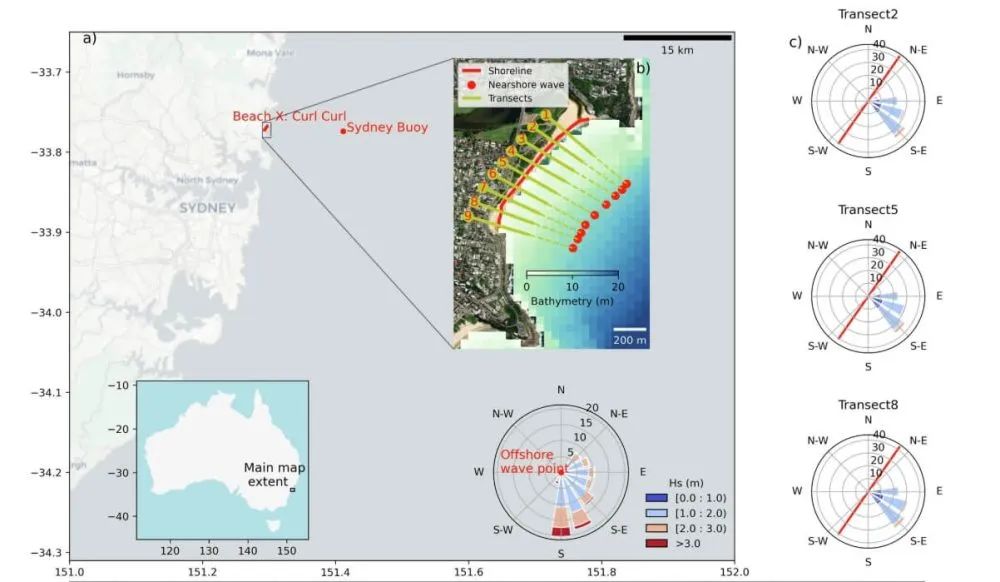

Le concours international de tests à l'aveugle ShoreShop2.0 est une forme extrêmement rigoureuse de collaboration scientifique. Les équipes participantes sont uniquement informées du site de test, désigné par un nom de code pour une baie ou une plage. Des informations clés, telles que sa localisation et son nom réel, sont dissimulées afin d'éviter que des connaissances préalables n'influencent le calibrage du modèle. De plus, les données sont traitées de manière confidentielle par sections : celles de 2019 à 2023 (court terme) et celles de 1951 à 1998 (moyen terme) sont volontairement occultées. Les modèles prédisent ensuite les changements du littoral à court et moyen terme, et leur exactitude est finalement vérifiée à l'aide des données confidentielles. Ce dispositif permet des comparaisons interdisciplinaires de modèles côtiers dans des conditions totalement inconnues.

Trente-quatre équipes de recherche issues de 15 pays ont soumis des modèles, dont 12 modèles basés sur les données et 22 modèles hybrides. Ces équipes provenaient d'institutions situées aux États-Unis, en Australie, au Japon, en France et dans d'autres pays. Cependant, les modèles soumis ne comportaient pas de modèles commerciaux tels que GENESIS ni les modèles physiques Delft3D et MIKE21.

Une comparaison a révélé que les modèles les plus performants pour les prévisions à court terme (cinq ans) étaient CoSMoS-COAST-CONV_SV (modèle hybride), GAT-LSTM_YM (modèle basé sur les données) et iTransformer-KC (modèle basé sur les données). Ces modèles ont atteint des erreurs quadratiques moyennes d'environ 10 mètres, comparables à l'erreur inhérente de 8,9 mètres des données de télédétection satellitaire du littoral. Cela indique que, pour certaines plages, les capacités prédictives des modèles approchent les limites des techniques d'observation. Bien entendu, d'autres modèles ont permis de mieux appréhender les variations du littoral.

Un résultat surprenant a été que le modèle hybride a obtenu des performances comparables à celles du modèle basé sur les données. CoSMoS-COAST-CONV_SV (modèle hybride) combine des processus physiques et des opérations de convolution, tandis que GAT-LSTM_YM (modèle basé sur les données) utilise un réseau d'attention graphique pour capturer les corrélations spatiales. Les deux modèles ont donné de bons résultats.

En matière de prévisions à moyen terme, la série LX-Shore (modèles hybrides) offre les prédictions les plus proches des données mesurées. En couplant les processus de transport sédimentaire littoral et latéral, ces modèles assurent une stabilité à long terme tout en présentant les réponses les plus cohérentes aux événements orageux extrêmes avec les données mesurées. Les prédictions de ces modèles indiquent qu'une seule tempête violente peut provoquer un recul transitoire du trait de côte allant jusqu'à 15 à 20 mètres, le rétablissement complet pouvant prendre deux à trois ans. La série CoSMoS-COAST offre une excellente stabilité, tandis que d'autres modèles peuvent souffrir de dérive à long terme et de surréaction.

Les résultats du modèle indiquent quequalité des donnéesLa résolution temporelle est un facteur limitant majeur de la performance du modèle. Bien que les données de télédétection satellitaire couvrent une vaste zone, leur faible résolution temporelle (généralement hebdomadaire à mensuelle) rend difficile la capture du rétablissement rapide après une tempête. De plus, le niveau instantané de la surface de l'eau est affecté par le déferlement des vagues et les marées, ce qui engendre des erreurs transitoires susceptibles d'affecter les prédictions du modèle.

L'étude a révélé que le lissage spatio-temporel des données, notamment par l'utilisation de techniques de filtrage bidimensionnelles robustes, peut améliorer significativement les performances du modèle. Par la suite, les modèles de test non masqués ont réduit leur erreur moyenne de 15 % grâce à un prétraitement optimisé des données.

Le lissage 2D robuste est une méthode de traitement du signal avancée, conçue spécifiquement pour traiter le bruit dans les données satellitaires côtières. Il s'agit essentiellement d'un algorithme de filtrage itératif basé sur la méthode des moindres carrés pondérés, et il est très robuste aux valeurs aberrantes telles que le bruit transitoire des vagues dans les images satellitaires.

Un autre facteur crucial pour les prédictions des modèles est la précision des données de vagues côtières. Actuellement, ces données souffrent de diverses erreurs, notamment des erreurs de conversion des données de réanalyse globale des vagues pour la zone côtière, des biais liés à l'extraction des paramètres de vagues à l'isobathe de 10 mètres plutôt qu'à la zone de déferlement, et une sous-estimation de l'impact des événements extrêmes due à l'utilisation des conditions de vagues moyennes journalières. Toutes ces erreurs peuvent affecter les prédictions des modèles.

Pour les prévisions à long terme, la plupart des modèles s'appuient sur la loi brownienne classique pour estimer l'impact de l'élévation du niveau de la mer. Cependant, cette loi suppose un apport sédimentaire infini et équilibré et ignore les effets du transport sédimentaire au large ainsi que les activités humaines, comme le rechargement des plages. Cela peut engendrer des biais importants dans les modèles.

S’appuyant sur la théorie du profil d’équilibre, la loi de Brown établit une relation linéaire entre l’élévation du niveau de la mer et le recul du trait de côte. Cette théorie postule qu’un profil côtier conserve une forme d’équilibre. Avec la montée du niveau de la mer, l’augmentation de l’espace disponible contraint ce profil d’équilibre à se déplacer vers l’intérieur des terres afin de maintenir sa forme par rapport au nouveau niveau marin. Par conséquent, la théorie postule que ce déplacement du profil côtier entraîne l’érosion de la couche supérieure de la plage, dont les matériaux se déposent au large, provoquant une élévation du fond marin côtier et maintenant ainsi une profondeur d’eau constante. La loi de Brown prédit que le recul du trait de côte peut être 10 à 50 fois supérieur à l’élévation du niveau de la mer, selon la pente de la plage.

Cette étude fournit les bases nécessaires à la sélection d'outils adaptés aux besoins spécifiques. Par ailleurs, le prétraitement des données est crucial ; un traitement adéquat peut parfois avoir un impact plus important que le modèle lui-même. Forts de l'expérience acquise avec ShoreShop 2.0, des améliorations peuvent être apportées aux données satellitaires et de vagues afin d'accroître la précision des prévisions. De plus, les effets incontrôlables des perturbations artificielles des plages dans les prévisions à long terme peuvent également impacter significativement les résultats. Enfin, l'absence de prise en compte de modèles commerciaux tels que GENESIS, Delft3D et MIKE21 constitue un problème majeur.

Gardiens de la frontière bleue : la mission de Frankstar sur 11 ans pour protéger nos océans et notre climat

Depuis plus de dix ans, Frankstar est à la pointe de la protection de l'environnement marin, s'appuyant sur des technologies de pointe et une rigueur scientifique sans précédent pour fournir des données océaniques et hydrologiques d'une qualité exceptionnelle. Notre mission va bien au-delà de la simple collecte de données : nous œuvrons à bâtir un avenir durable, en permettant aux institutions, aux universités et aux gouvernements du monde entier de prendre des décisions éclairées pour la santé de notre planète.

Date de publication : 11 août 2025