W obliczu zmian klimatycznych prowadzących do wzrostu poziomu mórz i nasilenia się burz, globalne linie brzegowe stoją w obliczu bezprecedensowego ryzyka erozji. Jednak dokładne przewidywanie zmian linii brzegowej jest trudne, zwłaszcza w odniesieniu do długoterminowych trendów. Niedawno międzynarodowe badanie ShoreShop2.0 oceniło wydajność 34 modeli prognozowania linii brzegowej poprzez ślepe testy, ujawniając aktualny stan wiedzy w dziedzinie modelowania linii brzegowej.

Linia brzegowa to dynamiczna granica między lądem a morzem, stale zmieniająca się pod wpływem fal, pływów, sztormów i wzrostu poziomu morza. Około 24% piaszczystych linii brzegowych na świecie cofa się w tempie przekraczającym 0,5 metra rocznie, a w niektórych obszarach, takich jak wybrzeże Zatoki Meksykańskiej w USA, roczna erozja przekracza nawet 20 metrów.

Prognozowanie zmian linii brzegowej jest z natury trudne i złożone, wymaga uwzględnienia współdziałania wielu czynników, w tym energii fal, transportu osadów i wzrostu poziomu morza. Dokładne prognozy na długie okresy czasu są jeszcze trudniejsze.

Nowoczesne modele prognozowania linii brzegowej można podzielić na trzy kategorie: pierwsza opiera się na symulacji fizycznej, np. Delft3D i MIKE21, wykorzystującej mechanikę płynów i równania transportu osadów; druga to model hybrydowy, łączący zasady fizyczne z metodami opartymi na danych, np. CoSMoS-COAST i LX-Shore; druga to model oparty na danych, który opiera się wyłącznie na technikach statystycznych lub uczenia maszynowego, np. sieci LSTM i architektury Transformer.

Pomimo dużej różnorodności modeli, brak ujednoliconych kryteriów oceny utrudnia porównywanie wydajności. Który model oferuje najdokładniejsze prognozy? Konkurs ShoreShop2.0 w formie ślepych testów stanowi doskonałą okazję do porównań interdyscyplinarnych.

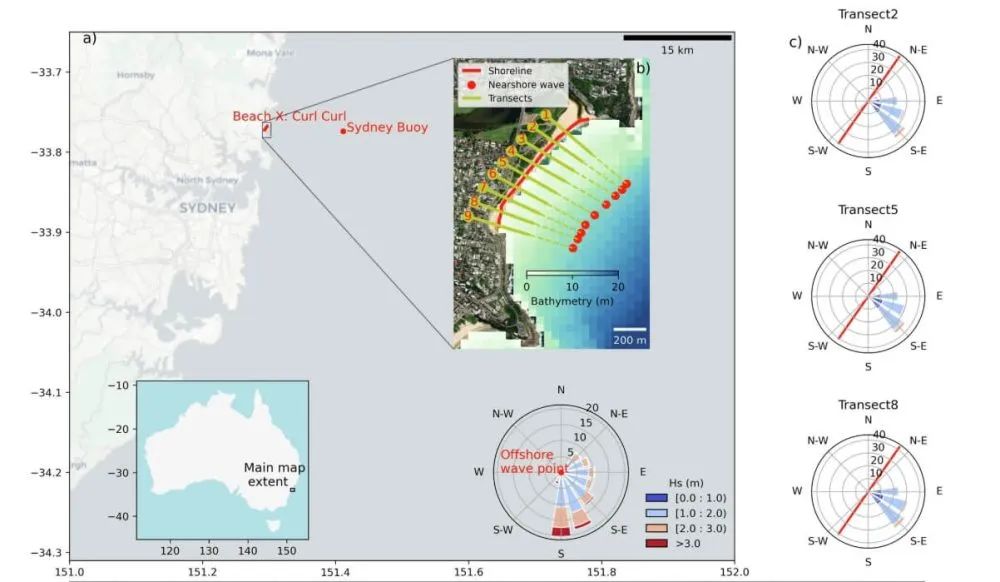

Międzynarodowy konkurs ShoreShop2.0 w ślepych testach to niezwykle rygorystyczna forma współpracy naukowej. Uczestniczące zespoły otrzymują jedynie informacje o miejscu testowym, czyli o kryptonimie zatoki lub plaży. Kluczowe informacje, takie jak lokalizacja i rzeczywista nazwa, są ukrywane, aby zapobiec wpływowi wcześniejszej wiedzy na kalibrację modelu. Co więcej, dane są objęte klauzulą poufności w sekcjach, a dane z lat 2019-2023 (krótkoterminowe) i 1951-1998 (średnioterminowe) są celowo ukrywane. Modele następnie przewidują krótko- i średnioterminowe zmiany linii brzegowej, ostatecznie weryfikując swoją dokładność za pomocą poufnych danych. Taka konstrukcja umożliwia interdyscyplinarne porównania modeli wybrzeża w całkowicie nieznanych warunkach.

Trzydzieści cztery zespoły badawcze z 15 krajów zgłosiły modele, obejmujące 12 modeli opartych na danych i 22 modele hybrydowe. Zespoły te pochodziły z instytucji ze Stanów Zjednoczonych, Australii, Japonii, Francji i innych krajów. Jednak w zgłoszonych modelach brakowało modeli komercyjnych, takich jak GENESIS oraz modeli opartych na fizyce Delft3D i MIKE21.

Porównanie wykazało, że najskuteczniejszymi modelami dla krótkoterminowych, pięcioletnich prognoz były CoSMoS-COAST-CONV_SV (model hybrydowy), GAT-LSTM_YM (model oparty na danych) oraz iTransformer-KC (model oparty na danych). Modele te osiągnęły błędy średniokwadratowe wynoszące około 10 metrów, co jest porównywalne z błędem naturalnym wynoszącym 8,9 metra w danych satelitarnych dotyczących linii brzegowej. Oznacza to, że w przypadku niektórych plaż możliwości predykcyjne modeli zbliżają się do granic możliwości technologii obserwacyjnych. Oczywiście inne modele były w stanie lepiej uchwycić zmiany w linii brzegowej.

Zaskakującym odkryciem był fakt, że model hybrydowy działał porównywalnie z modelem opartym na danych. CoSMoS-COAST-CONV_SV (model hybrydowy) łączy procesy fizyczne i operacje splotowe, podczas gdy GAT-LSTM_YM (model oparty na danych) wykorzystuje sieć uwagi grafów do rejestrowania korelacji przestrzennych. Oba modele działały dobrze.

W zakresie prognoz średnioterminowych, seria LX-Shore (modele hybrydowe) zapewnia prognozy najbardziej zbliżone do danych pomiarowych. Łącząc wzdłużbrzeżne i boczne procesy transportu osadów, modele te zachowują długoterminową stabilność, jednocześnie wykazując najbardziej spójne reakcje na ekstremalne sztormy z danymi pomiarowymi. Prognozy z tych modeli wskazują, że pojedynczy silny sztorm może spowodować przejściowe cofnięcie się linii brzegowej nawet o 15-20 metrów, a pełna odbudowa może zająć od dwóch do trzech lat. Seria CoSMoS-COAST oferuje doskonałą stabilność, podczas gdy inne modele mogą cierpieć na długoterminowy dryf i nadmierną reakcję.

Wyniki modelu wskazują, żejakość danychjest kluczowym czynnikiem ograniczającym wydajność modelu. Chociaż dane z teledetekcji satelitarnej obejmują szeroki obszar, ich rozdzielczość czasowa jest niska, zazwyczaj tygodniowa lub miesięczna, co utrudnia uchwycenie szybkiej regeneracji po sztormie. Co więcej, na chwilową krawędź wody wpływają fale i pływy, co prowadzi do błędów przejściowych, które mogą wpływać na prognozy modelu.

Badanie wykazało, że wygładzanie danych czasoprzestrzennych, takie jak zastosowanie solidnych technik filtrowania dwuwymiarowego, może znacząco poprawić wydajność modelu. Późniejsze modele testowe w trybie nieślepym wykazały średni błąd niższy o 15% dzięki zoptymalizowanemu wstępnemu przetwarzaniu danych.

Robust 2D Smoothing to zaawansowana metoda przetwarzania sygnału, opracowana specjalnie do przetwarzania szumów w danych satelitarnych z linii brzegowej. Zasadniczo jest to iteracyjny algorytm filtrowania oparty na ważonej metodzie najmniejszych kwadratów, charakteryzujący się wysoką odpornością na wartości odstające, takie jak szum fal przejściowych na obrazach satelitarnych.

Kolejnym kluczowym czynnikiem dla prognoz modeli jest dokładność danych dotyczących fal przybrzeżnych. Obecnie dane dotyczące fal obarczone są różnymi błędami, w tym błędami w konwersji danych z reanalizy fal globalnych na dane dotyczące fal przybrzeżnych, błędami wynikającymi z ekstrakcji parametrów fal na izobacie 10 metrów zamiast w strefie załamania oraz niedoszacowaniem wpływu zjawisk ekstremalnych poprzez wykorzystanie średnich dziennych warunków falowania. Wszystkie te błędy mogą wpływać na prognozy modeli.

W przypadku prognoz długoterminowych większość modeli opiera się na klasycznym prawie Browna, aby oszacować wpływ wzrostu poziomu morza. Prawo to zakłada jednak nieskończoną i zrównoważoną podaż osadów i pomija wpływ transportu osadów na morzu lub działalności człowieka, takiej jak zasilanie plaż. Może to prowadzić do znacznych błędów w modelach.

Opierając się na teorii profilu równowagi, prawo Browna zapewnia liniową zależność między wzrostem poziomu morza a cofaniem się linii brzegowej. Teoria ta zakłada, że profil wybrzeża zachowuje kształt równowagi. Wraz ze wzrostem poziomu morza, rosnąca przestrzeń akomodacyjna wymusza przesunięcie tego profilu równowagi w kierunku lądu, aby zachować jego kształt względem nowego poziomu morza. W konsekwencji, teoria zakłada, że wraz z przesunięciem profilu wybrzeża w kierunku lądu, górna warstwa plaży ulega erozji, a zerodowany materiał osadza się na morzu, powodując podnoszenie się dna morskiego w pobliżu brzegu, a tym samym utrzymanie stałej głębokości wody. Prawo Browna przewiduje, że cofanie się wybrzeża może być od 10 do 50 razy większe niż wzrost poziomu morza, w zależności od nachylenia plaży.

Niniejsze badanie stanowi podstawę doboru odpowiednich narzędzi w oparciu o specyficzne potrzeby. Co więcej, wstępne przetwarzanie danych ma kluczowe znaczenie; właściwe przetwarzanie danych może czasami mieć większy wpływ niż sam model. Bazując na doświadczeniu zdobytym dzięki ShoreShop 2.0, można udoskonalić dane satelitarne i dane falowe w celu zwiększenia dokładności prognoz. Co więcej, niekontrolowane skutki sztucznie zakłócanych plaż w prognozach długoterminowych mogą również znacząco wpływać na wyniki prognoz. Co więcej, brak udziału modeli komercyjnych, takich jak GENESIS, Delft3D i MIKE21, stanowi istotny problem.

Strażnicy Błękitnej Granicy: 11-letnia misja Frankstara mająca na celu ochronę naszych oceanów i klimatu

Od ponad dekady Frankstar jest liderem w dziedzinie ochrony środowiska morskiego, wykorzystując najnowocześniejszą technologię i naukową precyzję, aby dostarczać niezrównane dane oceaniczne i hydrologiczne. Nasza misja wykracza poza samo gromadzenie danych – jesteśmy architektami zrównoważonej przyszłości, wspierając instytucje, uniwersytety i rządy na całym świecie w podejmowaniu świadomych decyzji dla zdrowia naszej planety.

Czas publikacji: 11-08-2025