Der Klimawandel führt zu steigenden Meeresspiegeln und heftigeren Stürmen, wodurch die Küsten weltweit einem beispiellosen Erosionsrisiko ausgesetzt sind. Die präzise Vorhersage von Küstenveränderungen, insbesondere langfristiger Trends, stellt jedoch eine Herausforderung dar. Die internationale Kooperationsstudie ShoreShop2.0 bewertete kürzlich die Leistungsfähigkeit von 34 Küstenvorhersagemodellen mittels Blindtests und ermittelte so den aktuellen Stand der Technik in der Küstenmodellierung.

Die Küstenlinie bildet die dynamische Grenze zwischen Land und Meer und verändert sich ständig durch Wellen, Gezeiten, Stürme und den Anstieg des Meeresspiegels. Weltweit ziehen sich etwa 24 % der Sandküsten mit einer Geschwindigkeit von über 0,5 Metern pro Jahr zurück, und in einigen Gebieten, wie beispielsweise an der US-Golfküste, beträgt die jährliche Erosionsrate sogar mehr als 20 Meter.

Die Vorhersage von Küstenlinienveränderungen ist naturgemäß schwierig und komplex und erfordert die Berücksichtigung des Zusammenspiels mehrerer Faktoren, darunter Wellenenergie, Sedimenttransport und Meeresspiegelanstieg. Genaue Vorhersagen über lange Zeiträume sind noch anspruchsvoller.

Moderne Küstenvorhersagemodelle lassen sich in drei Kategorien einteilen: Die erste Kategorie basiert auf physikalischen Simulationen, wie beispielsweise Delft3D und MIKE21, die auf Strömungsmechanik und Sedimenttransportgleichungen beruhen; die zweite Kategorie umfasst Hybridmodelle, die physikalische Prinzipien mit datengetriebenen Methoden kombinieren, wie etwa CoSMoS-COAST und LX-Shore; und die dritte Kategorie umfasst datengetriebene Modelle, die ausschließlich auf statistischen oder maschinellen Lernverfahren basieren, wie beispielsweise LSTM-Netzwerke und Transformer-Architekturen.

Trotz der Vielzahl an Modellen erschwert das Fehlen einheitlicher Bewertungskriterien den Leistungsvergleich. Welches Modell liefert die präzisesten Vorhersagen? Der Blindtestwettbewerb ShoreShop2.0 bietet eine ideale Gelegenheit für interdisziplinäre Vergleiche.

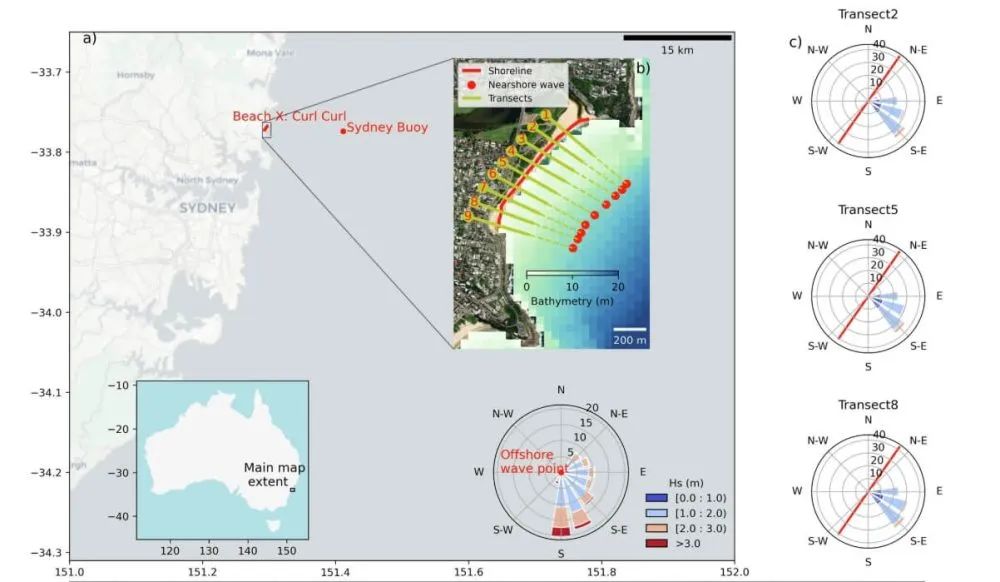

Der internationale Blindtestwettbewerb ShoreShop2.0 ist eine äußerst anspruchsvolle Form der wissenschaftlichen Zusammenarbeit. Die teilnehmenden Teams erfahren lediglich den Testort, der als Codename für eine Bucht oder einen Strand dient. Wichtige Informationen wie Lage und tatsächlicher Name werden geheim gehalten, um zu verhindern, dass Vorwissen die Modellkalibrierung beeinflusst. Darüber hinaus werden die Daten abschnittsweise vertraulich behandelt, wobei die Daten von 2019–2023 (kurzfristig) und 1951–1998 (mittelfristig) bewusst zurückgehalten werden. Die Modelle prognostizieren anschließend kurz- und mittelfristige Küstenlinienveränderungen und überprüfen ihre Genauigkeit schließlich anhand der vertraulichen Daten. Dieses Design ermöglicht interdisziplinäre Vergleiche von Küstenmodellen unter völlig unbekannten Bedingungen.

Vierunddreißig Forschungsteams aus 15 Ländern reichten Modelle ein, darunter 12 datengetriebene und 22 Hybridmodelle. Die Teams kamen von Institutionen in den USA, Australien, Japan, Frankreich und anderen Ländern. Allerdings fehlten unter den eingereichten Modellen kommerzielle Modelle wie GENESIS sowie die physikbasierten Modelle Delft3D und MIKE21.

Ein Vergleich ergab, dass die leistungsstärksten Modelle für kurzfristige Fünfjahresprognosen CoSMoS-COAST-CONV_SV (Hybridmodell), GAT-LSTM_YM (datengetriebenes Modell) und iTransformer-KC (datengetriebenes Modell) waren. Diese Modelle erreichten mittlere quadratische Fehler von etwa 10 Metern, vergleichbar mit dem systembedingten Fehler von 8,9 Metern in satellitengestützten Fernerkundungsdaten der Küstenlinie. Dies deutet darauf hin, dass die Vorhersagegenauigkeit der Modelle für einige Strände an die Grenzen der Beobachtungstechnologie stößt. Andere Modelle konnten Küstenlinienveränderungen natürlich besser erfassen.

Überraschenderweise schnitt das Hybridmodell vergleichbar mit dem datengetriebenen Modell ab. CoSMoS-COAST-CONV_SV (Hybridmodell) kombiniert physikalische Prozesse und Faltungsoperationen, während GAT-LSTM_YM (datengetriebenes Modell) ein Graph-Attention-Netzwerk nutzt, um räumliche Korrelationen zu erfassen. Beide Modelle erzielten gute Ergebnisse.

Hinsichtlich mittelfristiger Prognosen liefert die LX-Shore-Serie (Hybridmodelle) die genauesten Vorhersagen im Vergleich zu Messdaten. Durch die Kopplung von küstenparallelen und lateralen Sedimenttransportprozessen gewährleisten diese Modelle langfristige Stabilität und zeigen gleichzeitig die konsistentesten Reaktionen auf extreme Sturmereignisse im Vergleich zu Messdaten. Die Prognosen dieser Modelle deuten darauf hin, dass ein einzelner schwerer Sturm einen vorübergehenden Küstenrückgang von bis zu 15–20 Metern verursachen kann, wobei die vollständige Erholung potenziell zwei bis drei Jahre dauern kann. Die CoSMoS-COAST-Serie bietet eine ausgezeichnete Stabilität, während andere Modelle unter langfristiger Drift und Überreaktion leiden können.

Die Modellergebnisse deuten darauf hin, dassDatenqualitätist ein wesentlicher limitierender Faktor für die Modellleistung. Satellitenfernerkundungsdaten decken zwar ein großes Gebiet ab, ihre zeitliche Auflösung ist jedoch gering (typischerweise wöchentlich bis monatlich), was es schwierig macht, die schnelle Erholung nach einem Sturm zu erfassen. Darüber hinaus wird die momentane Wasserkante durch Wellenauflauf und Gezeiten beeinflusst, was zu vorübergehenden Fehlern führt, die die Modellvorhersagen beeinträchtigen können.

Die Studie ergab, dass die Glättung raumzeitlicher Daten, beispielsweise durch robuste zweidimensionale Filterverfahren, die Modellleistung deutlich verbessern kann. In späteren, nicht verblindeten Testmodellen konnte der durchschnittliche Fehler durch optimierte Datenvorverarbeitung um 15 % reduziert werden.

Robust 2D Smoothing ist eine fortschrittliche Signalverarbeitungsmethode, die speziell für die Rauschunterdrückung in Satellitendaten von Küstenlinien entwickelt wurde. Im Wesentlichen handelt es sich um einen iterativen Filteralgorithmus auf Basis gewichteter kleinster Quadrate, der gegenüber Ausreißern wie transientem Wellenrauschen in Satellitenbildern äußerst robust ist.

Ein weiterer entscheidender Faktor für Modellvorhersagen ist die Genauigkeit der küstennahen Wellendaten. Aktuell weisen diese Daten verschiedene Fehler auf, darunter Fehler bei der Umrechnung globaler Wellenreanalysedaten in küstennahe Daten, Verzerrungen durch die Bestimmung von Wellenparametern an der 10-Meter-Isobathe anstatt in der Brecherzone sowie die Unterschätzung der Auswirkungen extremer Wellenereignisse durch die Verwendung täglicher Durchschnittswerte. All diese Fehler können die Modellvorhersagen beeinträchtigen.

Für langfristige Prognosen stützen sich die meisten Modelle auf das klassische Brownsche Gesetz, um die Auswirkungen des Meeresspiegelanstiegs abzuschätzen. Dieses Gesetz setzt jedoch ein unendliches und ausgeglichenes Sedimentangebot voraus und vernachlässigt die Effekte des Sedimenttransports ins offene Meer oder menschlicher Aktivitäten wie der Strandaufspülung. Dies kann zu erheblichen Modellabweichungen führen.

Basierend auf der Theorie des Gleichgewichtsprofils beschreibt das Brownsche Gesetz einen linearen Zusammenhang zwischen Meeresspiegelanstieg und Küstenrückgang. Diese Theorie besagt, dass ein Küstenprofil eine Gleichgewichtsform beibehält. Mit steigendem Meeresspiegel zwingt der zunehmende Platzbedarf dieses Gleichgewichtsprofil dazu, sich landwärts zu verschieben, um seine Form relativ zum neuen Meeresspiegel beizubehalten. Folglich geht die Theorie davon aus, dass mit der landwärtigen Verschiebung des Küstenprofils die obere Strandschicht erodiert und das erodierte Material vor der Küste abgelagert wird. Dies führt zu einer Anhebung des küstennahen Meeresbodens und somit zu einer konstanten Wassertiefe. Das Brownsche Gesetz sagt voraus, dass der Küstenrückgang je nach Strandneigung 10- bis 50-mal größer sein kann als der Meeresspiegelanstieg.

Diese Studie liefert eine Grundlage für die Auswahl geeigneter Werkzeuge je nach spezifischem Bedarf. Darüber hinaus ist die Datenvorverarbeitung von entscheidender Bedeutung; eine korrekte Datenverarbeitung kann mitunter einen größeren Einfluss haben als das Modell selbst. Aufbauend auf den Erfahrungen mit ShoreShop 2.0 lassen sich Satelliten- und Wellendaten verbessern, um die Vorhersagegenauigkeit zu erhöhen. Auch die unkontrollierbaren Auswirkungen künstlich gestörter Strände auf Langzeitprognosen können die Ergebnisse erheblich beeinflussen. Zudem stellt die fehlende Beteiligung kommerzieller Modelle wie GENESIS, Delft3D und MIKE21 ein bedeutendes Problem dar.

Wächter der blauen Grenze: Frankstars 11-jährige Mission zum Schutz unserer Ozeane und unseres Klimas

Seit über einem Jahrzehnt ist Frankstar führend im Bereich des marinen Umweltschutzes und nutzt modernste Technologie und wissenschaftliche Präzision, um einzigartige Ozean- und hydrologische Daten zu liefern. Unsere Mission geht weit über die reine Datenerfassung hinaus – wir gestalten eine nachhaltige Zukunft und unterstützen Institutionen, Universitäten und Regierungen weltweit dabei, fundierte Entscheidungen für die Gesundheit unseres Planeten zu treffen.

Veröffentlichungsdatum: 11. August 2025